Cursul video LinkedIn despre deepfake vrea să te inițieze în arta falsului digital

Este bine să fim pregătiți minimal pentru a recunoaște manipulările și este bine să ne punem întotdeauna întrebări despre veridicitatea unor materiale de tip text, audio sau video, care ne sunt prezentate online.

Din profilul ei, Katie Jones părea conectată la scena politică a Washingtonului. Roșcata de 30 de ani obținuse un post la un grup politic influent. Pe LinkedIn, avea în rețea un secretar adjunct de stat, un asistent senior al unui senator și pe economistul Paul Winfree. Numai că această Katie Jones nu a existat vreodată, a aflat în 2019 The Associated Press. Persoana aceasta a făcut parte dintr-o armată de profiluri fantomă din rețeaua profesională LinkedIn.

Foto: The Associated Press

Era vorba despre un deepfake.

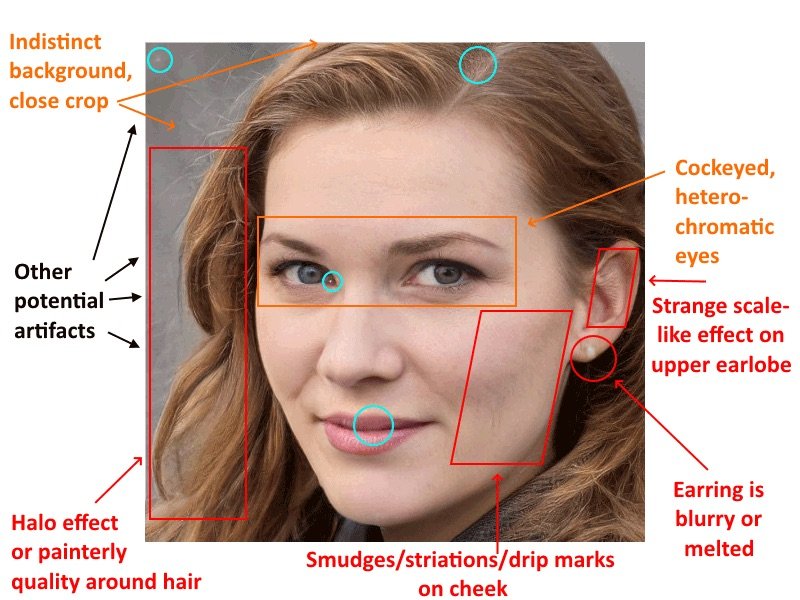

Imaginea de profil al lui Katie era generată pe computer. Cu puțin spirit de observație și un pic de experiență în editarea foto, puteai observa mici detalii ale feței care trădau faptul că în spatele imaginii tinerei se afla o rețea neuronală (inteligență artificială).

Foto: The Associated Press

Nu a fost singurul caz de acest tip. De aceea, nu este de mirare că LinkedIn a simțit de cuviință să lanseze pe platforma sa de cursuri o serie de video-uri despre deepfake. Pentru cei care n-au abonament la rețea, cursul poate fi accesat timp de 24 de ore. Dacă împărtășești cuiva link-ul și persoana intră în curs, primești încă 24 de ore de acces. Iar dacă nu ai abonament, poți încerca rețeaua gratuit timp de o lună și abia după aceea ți se vor lua bani din cont pentru următoarele luni. Dacă ai abonament, vei primi la final un certificat de absolvire.

Inițiere în deepfake

Ai nevoie de aproximativ 50 de minute pentru a urmări cele 11 video-uri din cadrul cursului împărțit pe trei secțiuni, plus o introducere și o concluzie.

„Deepfake-urile sunt producții manipulate (video sau audio) în care o persoană a fost înlocuită cu fața altcuiva și este făcută să apară ca și cum ar fi spus sau ar fi făcut ceva ce nu s-a întâmplat niciodată. Atunci când sunt folosite pentru a induce în eroare publicul, videoclipurile deepfake pot fi dezastruoase”, se arată în descrierea cursului.

În acest curs de bază, Ashley Kennedy oferă o introducere utilă asupra pericolelor și beneficiilor videoclipurilor deepfake. Ea creează, de asemenea, o imagine de ansamblu a tehnologiilor deepfake și oferă câteva instrumente pentru identificarea videoclipurilor de acest fel, precum și sugestii despre ce trebuie făcut atunci când suspectați sau observați un deepfake.

În introducere, se arată că, până de curând, numai cei care posedau tehnologii avansate puteau face astfel de manipulări. Astăzi însă, înlocuirile fețelor celor care apar în video-uri pot fi făcute chiar și pe smartphone.

O dovadă în acest sens sunt aplicațiile care răsar mai ales în preajma sărbătorilor, în care poți plasa fața ta sau a unui cunoscut peste cea a unui protagonist dintr-un clip de sezon din care reiese un dans amuzant, un interviu scurt, o prezentare inedită etc. Una dintre cele mai populare aplicații de acest tip este Reface.

Shallowfake, simplitatea manipulării

Nu toate clipurile manipulative trebuie să fie complicate. Shallowfake este o tehnică prin care se manipulează un aspect simplu al unui clip, cum ar fi viteza de redare. Printr-o asemenea modificare, poți face, de exemplu, pe cineva să pară beat sau drogat, cum s-a întâmplat în acest clip cu Nancy Pelosi, așa cum se arată în cursul de la LinkedIn:

Evident, publicul nu se pricepe sau nu se gândește să verifice asemenea știri video și își formează o impresie greșită despre personajul care apare astfel. O altă tehnică de tip shallowfake este să „îngheți” câteva fotograme, pentru a face ca o acțiune să pară mai lungă. De exemplu, în acest clip, pare că stagiara îi smulge din mână jurnalistului microfonul, deși, în realitate, gestul nu a fost deloc așa de brutal:

Audio din altă lume

Cursul continuă explicând cum se poate manipula prin audio: poți crea o voce pornind de la un text scris care este sintetizat de computer sau poți modula o voce existentă a cuiva în așa fel încât să pară a altei persoane. Sintetizarea vocii se poate face astăzi foarte simplu și există chiar aplicații gratuite în cloud, despre care am mai scris aici.

În ultimul caz dintre cele două amintite, este vorba chiar despre clonarea vocii unei persoane, care va include și inflexiunile cauzate de emoții. Imaginați-vă cum se poate folosi această tehnologie în scopuri teroriste, de exemplu, sau pentru a altera evenimentele în desfășurare! Dar tehnica poate fi și în folosul unor persoane care pot cere, de exemplu, la telefon, niște bani care să fie transferați într-un cont bancar, folosind o voce a cuiva cunoscut de către persoana apelată.

Utilizări în scop nobil

Când spunem deepfake, ne gândim la lucruri malefice. Dar tehnicile pot fi folosite și în scopuri benigne și chiar au fost folosite astfel, mai ales de către industria filmului. Probabil vă amintiți celebra peliculă „Forrest Gump”, în care personajul principal interacționează cu personalități din lumea politică și artistică, cum ar fi președintele Kennedy:

În filmul „The Irishman”, mai multe personaje au fost îmbătrânite artificial pe parcursul acțiunii, pentru a arăta trecerea firească a timpului peste fizicul lor:

De fapt, deepfake se bazează pe deep learning și, mai exact, pe două modele de învățare automată (machine learning):

- Primul model se bazează pe un set de date pentru a învăța. În cazul nostru, este vorba despre milioane de fotografii și multe clipuri video (dacă sunt disponibile) ale unei persoane.

- Al doilea model parcurge traseul invers: el învață care sunt acele manipulări realizate deja și apoi face în așa fel încât ele să nu mai fie considerate trucaje video.

Cursul de la LinkedIn conține și un interviu în două părți cu Noelle Silver de la HackerU, specialistă în inteligență artificială.

De asemenea, în cadrul cursului se amintește despre proiectul „In Event of Moon Disaster” („În eventualitatea unui dezastru selenar”) realizat de Massachusetts Institute of Technology. Proiectul a pornit de la întrebarea: „ce s-ar fi întâmplat dacă misiunea Apollo 11 ar fi eșuat și astronauții nu ar fi putut să se întoarcă acasă?” Era pregătit un discurs de urgență pentru această posibilitate, dar niciodată ținut de Richard Nixon, până când a fost folosită tehnologia pentru a-l „reînvia” pe președintele american și a-l pune să vorbească despre accident:

Așadar, deepfake face deja parte din viața noastră digitală, deși până acum vreo doi ani părea de domeniul științifico-fantasticului. Ca și în cazul știrilor false, este bine să fim pregătiți minimal pentru a recunoaște manipulările și este bine să ne punem întotdeauna întrebări despre veridicitatea unor materiale de tip text, audio sau video, care ne sunt prezentate online.

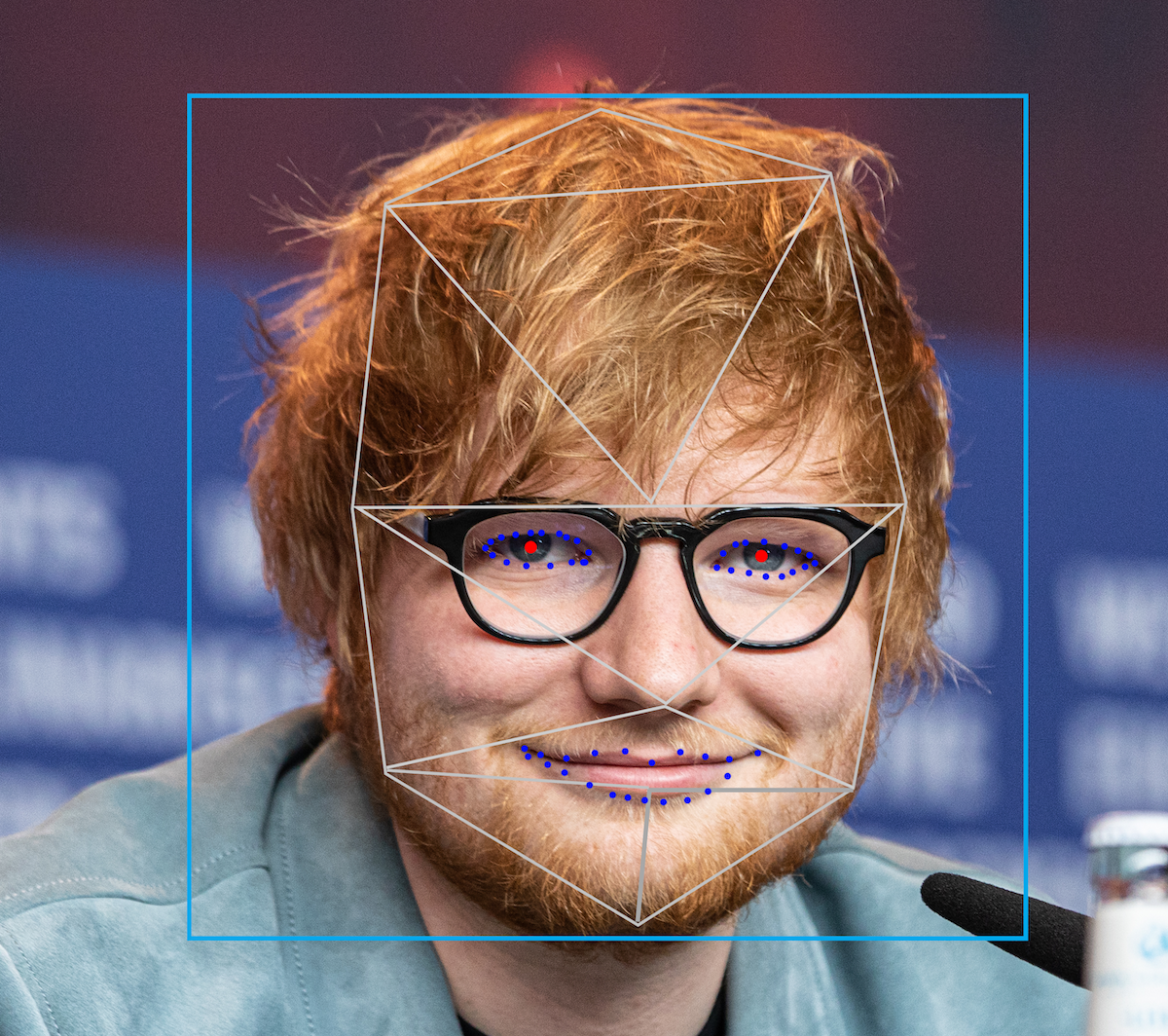

Foto: Dalhousie Gazette: a student-run newspaper for the Dal campus + Halifax – dalgazette.com (CC BY-SA 3.0)